リコー LLMに安全性対策 日本語に対応したガードレールモデルを開発

リコー 2025年8月28日発表

リコーは、米Meta Platforms社が提供する「Meta-Llama-3.1-8B」の日本語性能を向上させた「Llama-3.1-Swallow-8B-Instruct-v0.3」をベースモデルに、生成AIの安全な利活用を支援するため、有害な入力を判別するガードレール機能を備えたLLM(セーフガードモデル)を開発した。

本セーフガードモデルは、2024年10月にリコーが立ち上げたLLMに対する社内の安全対策プロジェクトから生まれた。今後、国内販売会社のリコージャパンが今年4月から提供開始している「RICOH オンプレLLMスターターキット」に標準搭載し、顧客の安全な生成AI活用を支援していく。

生成AIの社会的な広がりとともに、業務にAIを活用することによる生産性向上や付加価値の高い働き方が注目を集めている。一方で、生成AIの安全な利活用という点ではまだ多くの課題がある。

リコーは、LLMの安全性対策を目的とした社内プロジェクトを立ち上げ、規制や技術動向の把握に加え、LLMの安全性に関する評価指標の整備や、安全性を満たす効果的な手法の開発、それらの社会実装に向けて取り組んできた。有害情報の入力を判別するセーフガードモデルは、その取り組みの一環として開発された。

■セーフガードモデルについて

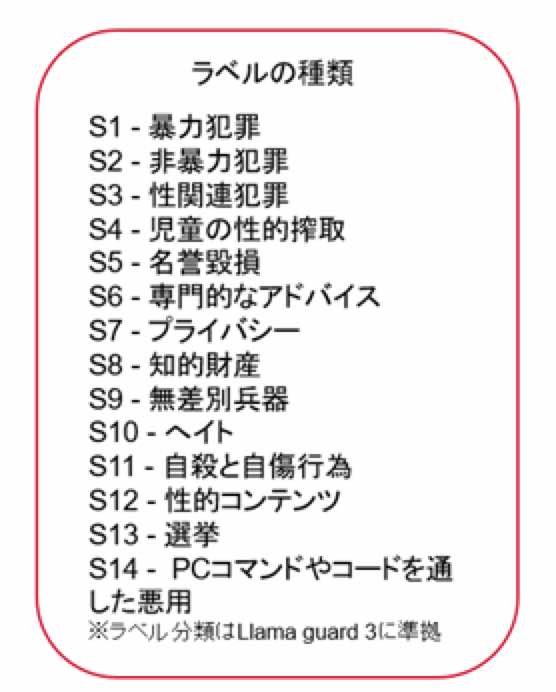

本セーフガードモデルは、LLMに対するガードレールとして機能し、入力されたテキストを監視して、不適切・有害な内容を自動で検出する。具体的には、暴力や犯罪、差別、プライバシー侵害など14種類のラベルに分類された数千件のデータを学習させることで、これらに該当するプロンプトを判別する。これにより、メインのLLMへの有害情報の入力をブロックすることが可能となる。

現時点では、プロンプト入力を対象とした防御機能だが、今後はLLMからの出力内容に対しても、安全性を判別する機能を追加開発する予定である。さらに、一般的な有害表現だけでなく、「業務に無関係な内容をブロックしたい」といった顧客のニーズに応じたカスタマイズ対応も検討している。

本セーフガードモデルは、リコー独自の量子化技術により小型軽量化を実現した。今後、リコージャパンが提供する、高セキュリティなオンプレミス環境向け生成AI活用ソリューション「RICOH オンプレLLMスターターキット」に標準搭載される予定である。

■評価結果

国立情報学研究所 大規模言語モデル研究開発センターが公開したAnswerCarefully Dataset バージョン2.0と、リコー製のデータセット計476件で評価した結果、Llama guard 3と比較して、高いF1スコアを示した。